Der perfekte Sturm

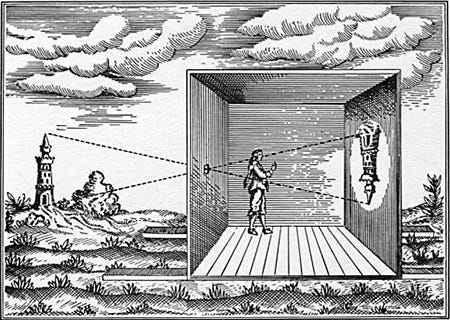

Von Günter Anders stammt die schöne Beobachtung der Prometheischen Scham – jener Spaltung, bei der der Schöpfer sich für die eigene Schöpfung entschuldigt. Auf zeitgemäße Weise lässt sie sich auch den Äußerungen Geoffrey Hintons entnehmen, jenes Forschers, der um 2012 herum die Künstliche Intelligenz revolutionierte, und zwar dadurch, dass er mithilfe einer anthropomorphen Gestalterkennungsoperation jenen ungeheuren Datenwust reduzierte, den das Machine Learning vordem benötigte.1 Die Ergebnisse dieser Humanisierungsaktion waren so durchschlagend, dass sich innerhalb weniger Jahre jene Software-Revolution ereignete, die uns nun in Gestalt von OpenAI, Chat-GPT und DALL-Es automatischer Bildgenerierung gegenübertritt, ganz zu schweigen von den zahllosen Anwendungen, die Text-To-Speech-Lösungen, AI gestützte Audio- oder Videoverbesserung oder automatische Übersetzungen anbieten. Ein Erfolg, der den spiritus rector dieser Unternehmung zum Bekenntnis veranlasste, das sei furchteinflößend. So beeindruckend all diese Ergebnisse zweifellos sind, so wenig jedoch haben sie mit dem zu tun, was man Intelligenz nennen könnte – nämlich einer geistigen Durchdringung. Das, was der Forscher in seinem magischen Spiegel ausfindig macht, ist nichts weiter als das Kondensat menschlicher Intelligenz, eine Art Massenseele. Strukturell wirkt die Künstliche Intelligenz wie die camera obscura der Renaissance, die auf mechanische Weise ein Engramm der Wirklichkeit darbot, das der Künstler (der dort im Innern hockte) auf seine Leinwand abpauste – mit dem Unterschied bloß, dass hier nicht die äußere Natur, sondern ein Abbild der Massenseele im magischen Spiegel erscheint – all dessen, was bereits gedacht, gesagt, getan worden ist.

So wie die Maler der Renaissance diese neue Bildverarbeitungstechnik mit größter Selbstverständlichkeit für sich nutzten – in Gestalt von fahrbaren camerae obsurae etwa, mit denen sich Landschaftspanoramen „aufnehmen“ ließen -, so ist klar, dass auch die neuartigen Werkzeuge sich in unser Gesellschaftsleben einhausen werden. Und ebenso klar ist, dass viele der Fertigkeiten, die heutzutage noch von der Aura des Künstlerischen überglänzt sind, an gesellschaftlicher (und ökonomischer) Hochschätzung einbüßen werden – während umgekehrt die intelligente, geistige Nutzung dieser Hilfsmittel zum eigentlichen Gegenstand des Kreativen wird. In paradigmatischer Form hat Marcel Duchamp bereits im Jahr 1917 diesen Prozess vorgeführt, mit der Ausstellung seines Fountain-Urinals.

Dabei erschöpfte sich des Künstlers persönlicher Beitrag in der Signatur seines Künstleravatars R. Mutt,2 im Titel des Werks sowie einer 90° Rotation des Gegenstand selbst. Duchamp bezeichnete das Kunstwerk selbst als readymade – womit signalisiert war, dass nicht das Objekt, sondern seine Wahrnehmung das eigentliche Kunstwerk darstelle. Man könnte in dieser kleinen Verschiebung die Geburt der Aufmerksamkeitsökonomie sehen – oder allgemeiner noch: jene Konzeptualisierungsbewegung der modernen Kunst, bei der das Kunstwerk (die ausgestellte Wahrnehmung) zu einem sozialen Akt wird.

Stellt man diese Form der ästhetisierten Wahrnehmung der Aufmerksamkeitsökonomie gegenüber, wie sie als kapitalistisches Rationale heutzutage praktiziert wird, sticht ins Auge, dass letztere nicht an einer Verfeinerung des Blicks interessiert ist, sondern nur daran, das Objekt des Begehrens gänzlich stromlinienförmig und massenkompatibel zu machen. Ziel ist das Massenprodukt, genauer: die Absorption eines massenhaften Aufmerksamkeitspotenzials. Dies hat zur Folge, dass man alles Widerständige und Unverständliche ausmerzt. Nur auf diese Weise nämlich kann man in jenen Rückkopplungsprozess des Trendens und der Viralität eintreten, jenen perzeptorischen circulus vituosus, bei dem bereits bestehende Erwartungen und Vorurteile bedient und bestätigt werden. Die Folge, wie man sie in den letzten drei Jahrzehnten hat beobachten können, ist eine fortschreitende Qualitätsminderung, eine beständig herabgesetzte Erwartung. Nun betrifft dies nicht bloß kulturelle Artefakte, sondern schlägt sich in einem niedrigeren Bildungsniveau nieder – und dies wiederum hat Auswirkungen auch aufs Berufsleben. An die Stelle des unmittelbaren Verhaltens tritt das Kalkül, ein Quotencalculus, der den Betreffenden nötigt, das eigene Verhalten nach Vorschrift oder an irgendwelchen Compliance-Vorgaben auszurichten. Despektierlich formuliert, nimmt der Auftritt nach Lehrbuch einen androiden Charakter an – ein Gebaren, das man am Verhalten von Call-Center-Mitarbeitern in vivo studieren kann. Strukturell entspricht dies der Logik des machine learning, wird der Einzelfall doch auf ein gesellschaftlich akzeptables Muster reduziert, lebendige Münze, wenn man so will. Dieses Formatierungsbestreben lässt sich in Reinform am Bildungssystem selbst studieren, das in einem beständigen Evaluierungsprozess, bei fortschreitender Kleinteiligkeit, darauf abzielt, ein zuvor im Detail festgelegtes Vermögen zu reproduzieren. Dass man im Modularisierungswahn das humanistische Bildungsideal – und damit die Wertschätzung des Einzelnen – hat beerdigen müssen, wird dabei als Kollateralschaden, ja als Zwangsläufigkeit eingepreist. Ärger noch ist, dass das gesellschaftliche Formatierungsbedürfnis auf ein Maschinenideal hinausläuft (euphemistisch als ›Kanonisierung‹ betitelt oder als Kompetenz maskiert). Entscheidend ist, dass, wie im Falle der Fließbandproduktion, der discours de la mèthode vorgegeben und die Lehrkraft nichts weiter ist als das ausführende Organ. Ein überaus absurdes Beispiel dieser Technik ist der multiple choice-Test, der seit den 70er Jahren die Bildungsinstitutionen geflutet hat. Von B.F. Skinner als eine eine Art stimulus-response Apparatur entworfen, bestand das Ziel darin, dem mit dieser Maschine interagierenden Zögling ein unmittelbares Feedback zu geben – also das, was mit einiger Verzögerung die Computerspiele realisiert haben.

Dass diese Maschinerie ihren Siegeszug nicht in der ursprünglichen Gestalt, sondern auf Papier davongetragen hat, ist eine Ironie der Geschichte, die an eine Episode aus der Zeit des Buchdrucks erinnert. Denn weil die Mönche bereits im 12. Jahrhundert ein hoch arbeitsteiliges Bibel-Redaktionssystem entworfen hatten, war ihre Reaktion auf die Lieferung einer Gutenberg-Bibel ebendiese: Jeder Mönch nahm sich die Bibelpassage vor, auf die er spezialisiert war, und prüfte sie auf Druckfehler – eine Arbeit, die man mit jedem einzelnen der gelieferten Bücher wiederholte. So wie die Mönche mit dieser Aktion die Logik der pecia bestätigten, so bestätigt die Übertragung des Multiple Choice aufs Papier, dass man selbst dort, wo man den Humanismus der Gutenberg-Galaxie opfert, doch immer ihren Techniken verhaftet bleibt – einem digitalen Analphabetismus, wenn man so will.

Analysiert man die Ausgangsbedingungen, auf welche die AI-Revolution trifft, so könnte man geradezu von einem perfekten Sturm sprechen. Denn die Künstliche Intelligenz trifft auf eine Gesellschaft, die auf gleich mehreren Ebenen eine Wertekrise durchleidet, ja, die, anstatt sich der Zukunft zu öffnen, sich dabei verausgabt, eine dysfunktionale Gesellschaftsmaschine aufrechtzuerhalten, ein Betriebssystem, das seine Prägung durchs mechanische Weltbild nicht verleugnen kann. Bereits der Computerpionier Charles Babbage hat in seiner Economy of Machinery and Manufactures diesen Sachverhalt höchst präzise analysiert. Denn je länger sich eine Gesellschaft der Maschinen-Ratio verweigert, desto größer wird das Potenzialgefälle und umso schockhafter die Ersetzung der menschlichen Arbeit durch das Maschinenprogramm. Genau das ist die die derzeitige Situation – und sie erklärt, warum allein das Spiel mit Chat GPT soetwas wie eine geistige Erschütterung bewirkt, warum Lehrer oder Professoren darüber nachsinnen, ob das, was sie von ihren Eleven untergeschoben bekommen, maschinengeneriert sein könnte. Wenn diese Ängste vor allem davon künden, wie weit sich die Bildungspraxis von einem emphatischen Bildungsideal entfernt hat, so tritt darin noch ein zweiter Grundirrtum hervor - die Vorstellung nämlich, dass die Künstliche Intelligenz irgendetwas anderes anderes sein könnte als ein magischer Spiegel.

Diese Fixierung auf das Unheimliche, die Golem-Existenz, mag einen wunderbaren Stoff für eine gothic novel abgeben, ein digitalisiertes Frankenstein-Remake, sie überblendet, dass man es hier nicht mit einem ethischen Dilemma, sondern vor allem einer Rationalisierungsfrage zu tun hat (und selbige brennt vor allem dort auf den Nägeln, wo die Ratio versagt). Denn wenn die Computerwelt sich an die Stelle von menschlichen Tätigkeiten zu setzen vermag, so geschieht dies überall dort, wo man sich mit dem Durchschnitt und mit mechanischen, routinehaften Arbeitsabläufen begnügt. Und weil jede Arbeit, die sich in Routinen erschöpft, sich digitalisieren lässt, verschwindet sie über kurz oder lang im Museum der Arbeit. Wenn in der Corona-Krise die Vorzüge des Präsenz-Unterrichts an die Tafel gemalt worden sind, so bezeugt die nun mit aller Macht zutage tretende Bildungskatastrophe, dass es mit der Präsenz eines Lehrers allein nicht getan ist – noch dazu, wenn seine Aufgabe sich in der eines Erfüllungsgehilfens erschöpft. Würde man sich ernsthaft die Aufgabe vornehmen, das gesellschaftliche Rationalisierungpotenzial auszuschöpfen, käme dies wohl einer Form der gesellschaftlichen Selbstdemontage gleich – steht zu befürchten, dass die Einsparungspotenziale weit größer sein werden als dies durch die Einführung des Fließbandes in den 20er Jahren der Fall war. Vielleicht noch fataler als dieser Rationalisierungsschock könnte sein, dass es unter den Bedingungen der Aufmerksamkeitsökonomie wenig Anreize gibt, sich auf aufwändige Weltverbesserungsprojekte einzulassen – wird man stattdessen die Substitution von Menschen durch Maschinen vorziehen (müssen).

In der Tat ist es unter den obwaltenden Umständen höchst unwahrscheinlich, dass die Möglichkeiten der Künstlichen Intelligenz freisetzen, wovon die Computerpioniere der Frühzeit geträumt haben: eine Augmentierung der Weltintelligenz. Lässt man sich jedoch auf diesen utopischen Blickwinkel ein, so könnte man, statt sich in Dystopien zu ergehen, ein ganz anderes Bild zeichnen. Denn begreift man die AI als eine Form des dienstbaren Geistes, eines nun jedermann zugänglichen Persönlichen Assistenten, ist evident, dass dieser seinem Meister die erstaunlichsten Dienste zu leisten vermag, umsomehr, als der Assistent über unbegrenzte Geduld und ein fast unerschöpfliches Gedächtnis verfügt – was ihn nicht bloß zu einem servilen Hausdiener, sondern zu einem verlässlichen Alltagsgefährten disponiert. Denn anders als der Lehrer, der eine Klasse (einer Schülerkohorte) gegenübersteht, hat man es hier mit einer vollständig individualisierten Ausgangssituation zu tun. Und dies erlaubt, dass man die Idiosynkrasien und Besonderheiten des Einzelnen in den Blick nehmen und darauf eingehen kann. Oder anders gesagt: Der Hauslehrer, der im bildungsbeflissenen 18. Jahrhundert das Privileg der Besitzenden war, lässt sich solcherart demokratisieren. Nun hat der persönliche Assistent einen großen Vorteil: Anders als der Lehrer verfügt er über unbegrenzte Zeit und über unbegrenzte Geduld, vor allem aber kann er sich, mit einem fast unbegrenzten Gedächtnis begabt, auf seinen Zögling einstellen. Weil die Interaktionen gespeichert und metrisiert werden, lässt sich erstmals von einem Bildungscurriculum sprechen. Und hier wird nicht nur der einzelne Nutzer, sondern auch die Autorität evaluiert, die hinter dem Programm steckt. Und damit wird die entscheidende Frage gestellt, die unter den Bedingungen der Aufmerksamkeitsökonomie ausgespart bleibt: Was ist das Menschheitsbild, auf das die Bildungsanstrengungen abzielen? Es ist evident, dass das dingfest gemachte Mittelmaß (die sogenannte Künstliche Intelligenz) hier nicht der Referenzrahmen sein kann, sondern dass man darüber hinausgehen muss. Mehrwert, so hat schon Marx höchst treffend formuliert, schafft nur der Mensch. Weil sich unter den Bedingungen der Aufmerksamkeitsökonomie eine Limbo-Ökonomie herausgebildet hat3, darüberhinaus die tiefe Wertekrise der Industriegesellschaften nicht einmal in Ansätzen durchbuchstabiert worden ist, steht zu befürchten, dass das, was die Befreiung von eintöniger, routineförmoger Arbeit bedeuten könnte, vor allem in zerstörerischer Form, als ein perfekter Sturm durchsetzen wird.

Die Grundfrage Hintons, die sich zum Back propagation-Strategem ausdifferenzierte, bestand darin, wie man einen Computer mit einem Vermögen ausstatte, welches an die menschliche Gastalterkennung heranrückt. Denn letztere bedarf um Gegensatz zu einem klasisschen machine learning-Algorithmus nur einer geringen Anzahl von Beispielen, um ein Muster zu erkennen. Der Aufsatz erschien 2012 unter dem Titel: ImageNet Classification with Deep Convolutional Neural Networks.

Der Name bezog sich einerseits auf die Firma Mott Iron Works, anderrseits auf eine beliebte Figur aus einem Comic Strip Bud Fisherrs, Mutt & Jeff.

Dazu ein Vortrag, den ich dazu im Jahr 1999 gehalten habe

– und die englische Fassung eines Essays, der unter dem Titel Im Arbeitsspeicher erstmals 1990 in einem Buch zur Sozialphilosophie der industriellen Arbeit erschienen ist: